Que significa Destilar Conocimiento de una Red Neuronal?

La destilación de conocimiento (o knowledge distillation en inglés) es un proceso utilizado en el campo del aprendizaje automático y la inteligencia artificial para transferir el conocimiento de un modelo grande y complejo, llamado modelo maestro o profesor , a un modelo más pequeño y eficiente, conocido como modelo estudiante . El objetivo principal de este proceso es reducir el tamaño del modelo sin sacrificar demasiada precisión o rendimiento, lo que permite que el modelo estudiante sea más rápido, consuma menos recursos computacionales y sea más adecuado para su implementación en dispositivos con limitaciones de hardware, como teléfonos móviles o sistemas embebidos.

Cómo funciona la destilación de conocimiento?

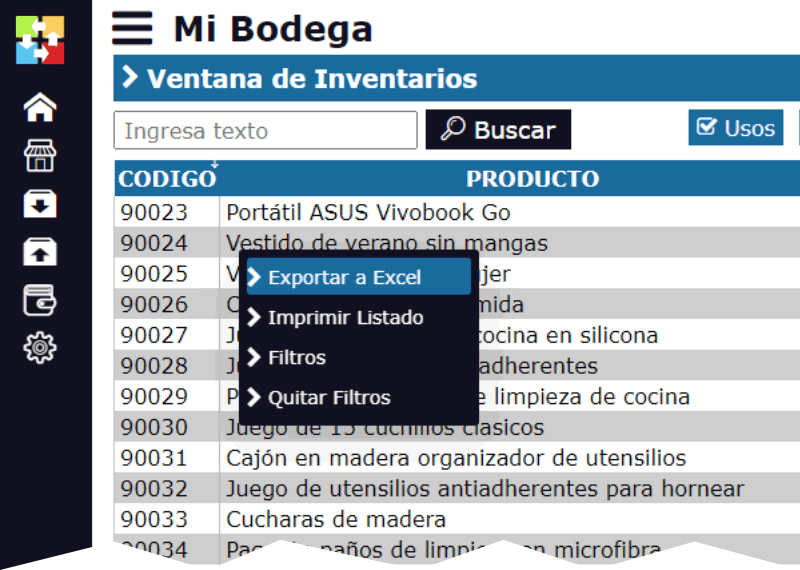

El proceso de destilación implica los siguientes pasos clave:

- Modelo Maestro (Profesor) : El modelo maestro suele ser un modelo grande y complejo, entrenado previamente en grandes cantidades de datos y con una alta capacidad de generalización. Este modelo puede ser muy preciso, pero también puede ser costoso en términos de tiempo de inferencia y consumo de recursos.

- Generación de Predicciones Suaves : En lugar de usar solo las etiquetas originales del conjunto de datos (las etiquetas "duras"), el modelo maestro genera predicciones "suaves" (soft labels ), que son distribuciones de probabilidad sobre todas las clases posibles.

Estas probabilidades suelen ser más informativas que las etiquetas duras porque contienen información sobre cuán segura está la red de sus predicciones.

Por ejemplo, si tienes un problema de clasificación con tres clases, el modelo maestro podría predecir algo como [0.7, 0.2, 0.1], indicando que está bastante seguro de que la clase correcta es la primera, pero también tiene alguna incertidumbre sobre las otras dos clases. - Entrenamiento del Modelo Estudiante : El modelo estudiante se entrena para imitar las predicciones del modelo maestro. En lugar de aprender directamente de las etiquetas originales, el modelo estudiante aprende a replicar las distribuciones de probabilidad generadas por el modelo maestro.

Para ello, se utiliza una función de pérdida especial, como la pérdida de entropía cruzada entre las predicciones del modelo estudiante y las predicciones suaves del modelo maestro.

Opcionalmente, el modelo estudiante también puede ser entrenado con las etiquetas originales del conjunto de datos para mejorar aún más su rendimiento. - Temperatura en la Función Softmax : Un truco común en la destilación de conocimiento es ajustar la "temperatura" de la función softmax utilizada para generar las predicciones suaves. La temperatura controla qué tan "suave" o "aguda" es la distribución de probabilidad. Una temperatura más alta produce distribuciones más suaves, lo que ayuda al modelo estudiante a capturar mejor las relaciones sutiles entre las clases.

Durante la inferencia, la temperatura se vuelve a ajustar a 1 para obtener predicciones más precisas. - Optimización del Modelo Estudiante : Una vez que el modelo estudiante ha sido entrenado para imitar al modelo maestro, se puede optimizar aún más para mejorar su eficiencia y rendimiento en tareas específicas. Esto puede incluir técnicas como la poda de pesos, la cuantización o la optimización de arquitecturas.

Ventajas de la Destilación de Conocimiento

- Reducción del tamaño del modelo : Los modelos estudiantes suelen ser mucho más pequeños y requieren menos recursos computacionales que los modelos maestros.

- Aceleración de la inferencia : Al ser más pequeños, los modelos estudiantes pueden realizar inferencias más rápidas, lo que es crucial en aplicaciones en tiempo real.

- Menor consumo de energía : Los modelos más pequeños consumen menos energía, lo que es ideal para dispositivos móviles o de bajo consumo.

- Mantenimiento de la precisión : Aunque el modelo estudiante es más pequeño, puede mantener una precisión cercana a la del modelo maestro, especialmente si se utiliza una buena estrategia de destilación.

Ejemplo Práctico

Imagina que tienes un gran modelo de lenguaje como GPT-3, que es extremadamente poderoso pero también muy grande y costoso de ejecutar. Usando la destilación de conocimiento, puedes entrenar un modelo más pequeño, como DistilGPT-2, que es significativamente más rápido y eficiente, pero aún conserva una buena parte de la capacidad del modelo original.

En resumen, la destilación de conocimiento es una técnica valiosa para crear modelos más pequeños y eficientes a partir de modelos grandes y complejos. Permite transferir el conocimiento acumulado por un modelo maestro a un modelo estudiante, facilitando la implementación de modelos de IA en entornos con restricciones de recursos sin sacrificar demasiado rendimiento.